( ͡°( ͡° ͜ʖ( ͡° ͜ʖ ͡°)ʖ ͡°) ͡°)

Text Prompts

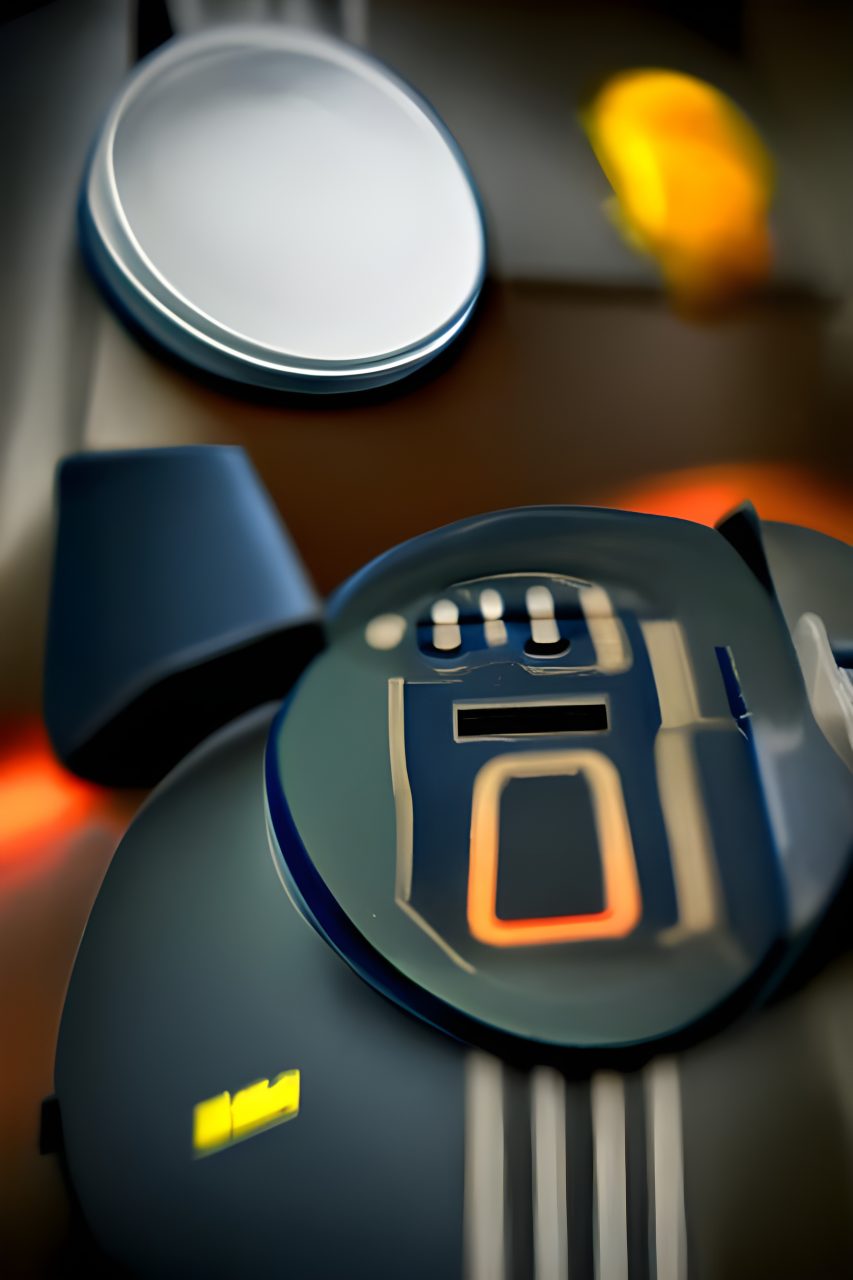

“heroic robotic vacuum cleaner in hall stock photo bokeh DSLR Unreal Engine HDR flickering light Kodak Ektar chromatic aberration ambient occlusion volumetric lightning tilt shift 35 mm 8k tilt shift” – weight: 1

Initial Resolution

Low

Runtime

Short

Seed

301597

Overall Prompt Weight

1

Accuracy boost

On

Conclusion + credits

What connects the devices and technologies presented in this project is the notion of ‘a better life’ these tools are supposed to bring, without much questioning of what a better life should be (the ‘device paradigm’ of Albert Borgmann). The amplification of technological structures of comfort and care creates neither total control nor total autonomy of the household unit.

The notion of a home that is safe from illnesses, safe from outside presents an illusion, or, rather, a simulation. Simulation has a reference to a model, but not necessarily to physical space: this is also the case with the images presented in this project.

The images you can see here are a result of image generation using the artificial neural network CLIP. An artificial neural network is a series of algorithms that tries to recognize underlying relationships in a set of data in a process that is similar to the human brain’s operations: there are signals being sent, processed, and received by neurons. In this sense, neural networks refer to systems of neurons (called nodes in this case).

CLIP is an artificial neural network model which combines knowledge of English language concepts and the semantic knowledge of images. The acronym CLIP comes from Contrastive Language-Image Pre-Training. It was first published by OpenAI in January 2021. [57] The main idea behind CLIP is to pre-train a neural language model and an image classification model which together use vast amounts of image data extracted directly from the Internet with their respective captions. [58] Once it is trained, this neural network can generate new images from nothing but random noise.

The neural network was given starting images from Martina Šimkovičová. The final works presented here were generated not from random noise, following the text prompts, but interpreting the input photographs in a semantic way.

The series of images, speaking of its origin, is a resolution of a loop of reality fragmentation, its technical caption, its decoding, and recoding. The very idea of mimicking reality through keywords and datasets seems to me as an ideal means to speak of the metadata society (Matteo Pasquinelli’s term) [59] in which the large datasets as sources of cognitive capital and political power aren’t only accumulated, but meta-analyzed and used for interpretation and forecasting possible future(s).

[57] https://openai.com/blog/clip/

[58] https://towardsdatascience.com/generating-images-from-prompts-using-clip-and-stylegan-1f9ed495ddda

[59] https://matteopasquinelli.com/metadata-society/

Credits

Supported by Slovak Arts Council

Images Martina Šimkovičová

Texts Martina Šimkovičová

Design Alžbeta Halušková

Translation and proofreading: Nina Vlhová

Coding: Matúš Bosák

Doslov

Spoločným menovateľom zariadení a technológie prezentovaných v tomto projekte je predstava „lepšieho života“, ktorý nám majú tieto nástroje sprostredkovať. Avšak práve nad tým, ako by mal vlastne „lepší život“ vyzerať, sa často nezamýšľame (device paradigm – „paradigma zariadení“ Alberta Borgmanna). Zosilnenie technologických štruktúr komfortu a starostlivosti nevytvára ani úplnú kontrolu, ani úplnú autonómiu domácej jednotky.

Predstava domova, ktorý je zvonku bezpečný a chránený pred chorobami, predstavuje ilúziu, alebo skôr simuláciu. Simulácia odkazuje na model, ale nie nevyhnutne na fyzický priestor: Tak vznikli aj obrázky prezentované v tomto projekte.

Obrázky, ktoré máte pred očami, sú výsledkom generovania obrázkov pomocou umelej neurónovej siete CLIP. Umelá neurónová sieť je séria algoritmov, ktoré sa snažia rozpoznať základné vzťahy v súbore údajov v procese, ktorý je podobný operáciám ľudského mozgu: Neuróny odosielajú, spracúvajú a prijímajú signály. V tomto zmysle sa neurónové siete týkajú systémov neurónov (v tomto prípade nazývaných uzly).

CLIP je model umelej neurónovej siete, ktorý kombinuje znalosti anglických pojmov a sémantickú znalosť obrázkov. Skratka CLIP pochádza z Contrastive Language-Image Pre-Training. Prvýkrát ho zverejnila spoločnosť OpenAI v januári 2021. [57] Hlavnou myšlienkou CLIP-u je predbežné trénovanie modelu neurónového jazyka a modelu klasifikácie obrázkov, ktoré spolu využívajú obrovské množstvo obrazových údajov extrahovaných priamo z internetu s príslušnými popismi. [58] Keď je táto neurónová sieť natrénovaná, dokáže generovať nové obrázky len z náhodného obrazového šumu.

Neurónová sieť dostala štartovacie obrázky od Martiny Šimkovičovej. Prezentované finálne práce nevznikli z náhodného zvuku podľa textových pokynov, ale interpretovali vstupné fotografie sémantickým spôsobom.

Vznik tejto série obrazov je výsledkom slučky fragmentácie reality, jej technického popisu, jej dekódovania a prekódovania. Samotná myšlienka napodobňovania reality prostredníctvom kľúčových slov a dátových množín sa mi javí ako ideálny spôsob, ako viesť diskusiu o metadátovej spoločnosti (metadata society, termín Mattea Pasquinelliho) [59], v ktorej sa veľké dátové množiny ako zdroje kognitívneho kapitálu a politickej moci nielen hromadia. ale sú aj metaanalyzované a použité na interpretáciu a predpovedanie možnej budúcnosti, či viacerých budúcností.

Redakcia

Vznik diela z verejných zdrojov podporil Fond na podporu umenia formou štipendia.

Obrázky Martina Šimkovičová

Texty Martina Šimkovičová

Dizajn Alžbeta Halušková

Preklad a korektúry: Nina Vlhová

Kódovanie: Matúš Bosák

5. Vacuum cleaner initial image

5. Vacuum cleaner initial image